- HOME

- ����

- �T�C�G���X���e�N�m���W�[

- �ʐM���x���ォ��_�Ԍ�����R���s���[�^�Z�p�̊J������—���N�������V�X�e���S�̂̕ϊv—

�ʐM���x���ォ��_�Ԍ�����R���s���[�^�Z�p�̊J������

—���N�������V�X�e���S�̂̕ϊv—

�R���s���[�^���H�w�� �l�b�g���[�N���f�B�A�w�� ���c�@�L �u�t

���N�������V�X�e���S�̂̕ϊv

�@�R���s���[�^�̗��j�ɂ����ẮA�ʐM���x�̌����CPU�̏����\�͂̌���ƁA����ɂƂ��Ȃ����[�U�̎g�����̕ω������܂��āA����Ȃ�Z�p�̔��W�����߂���Ƃ����A�㏸�̃X�p�C�������J��Ԃ���Ă��܂����B���݁A���̃X�p�C�������V�X�e���S�̂ɂ������ϊv���ĂыN�������Ƃ��Ă��܂��B���̈�[�͂��łɍŐ�[�̃T�[�r�X�Ŏ��ۂɎg���A�V�������C�t�X�^�C�����������ɂ����炵�܂����B�߂������A�����Ɛg�߂ɗ��p����邱�ƂŁA�����S�ʂɕϊv���N������������܂���B�l�b�g���[�N�V�X�e���������̈��c�L�搶�ɁA�ʐM���x�̌��オ�����炷�R���s���[�^�V�X�e���S�̂̕ϊv�ɂ��Ă��b�����������܂����B

�オ�葱����ʐM���x

�@�R���s���[�^�ƌĂׂ���̂��o�ꂵ�Ă��炨�悻70�N�B���̊ԂɃR���s���[�^�̏����\�͂͋����قnj��サ�܂����B

�@����ƕ��s���ăR���s���[�^�l�b�g���[�N���܂��A���̏����\�͂��グ�����Ă��܂��B

�@�@1960�N��̋�s�Ɩ�����ɁA�l�b�g���[�N���p�̐���͍L�܂�A���ł͂قƂ�ǂ̐l���X�}�[�g�t�H����p�\�R�����疈���C���^�[�l�b�g����C�̂悤�ɓ��Ɉӎ��������p���Ă��܂��B

�@��������������̂͒ʐM�̍������ł��B1960�N��ɂ͈�b�Ԃ�300�r�b�g��1�قǂ�������Ȃ������̂ł����A1980�N�㍠����Z�p�J���ɂ���ċ}���ɐ��\���グ�A���܂⍑���ł͖��b 100���K�r�b�g�i1���r�b�g�j�̃C���^�[�l�b�g�ڑ��T�[�r�X�����y���Ă��܂��B�i���̖��b100���K�r�b�g�A���Ȍ�100Mbps(Mega�Abits�Aper�Asec)�Ə����܂��j

��1�@�r�b�g�̓f�[�^�̒P�ʂ̈�ŁA1�r�b�g��0��1�̓�̒l�����Ă�B�r�b�g8����0�`255�܂ł̒l���\���ł��邪�A���ꂪ�i�F�������́j1�o�C�g�B

�V�X�e���\���̕ω�

�@�ł���f�[�^�̗ʂ�������ƁA���[�U�̎g�������ς��܂��B

�@Web ���L�܂�n�߂� 1994�N���͂������������ƐÎ~�悾���ł������A���ł͓���A�}�E�X�ł��肮��ƈړ��ł���n�}�A�Q�[���Ȃǂ�������̂�����Ă��܂��B

�@�����ăV�X�e���̍\�����̂��̂ɂ��ω�������܂��B

�@2005�N���A���́u���肮��ƈړ��ł���n�}�v�ł���Google Maps����{�Ƃ��đ����̃A�v���P�[�V������Web�u���E�U��Ŏg����悤�ɂȂ�܂����B

�@����܂Ńp�\�R���ƌ����u�\�t�g�E�F�A�v���C���X�g�[�����Ďg�����̂ł������A���ł̓��C���A�J�����_�[�ȂǑ����̍�Ƃ��u�T�[�r�X�v�Ƃ��ăl�b�g���[�N�̌��������ŏ��������X�^�C���ɂȂ�܂����B

����ȃR���s���[�^�Ƃ��Ẵf�[�^�Z���^�[

�@�����ŋ߁A�}���Ɋg�債���T�[�r�X�̈�ł���Facebook�̃��[�U����8.5���l��2�ł��B

�@���̐��E���̃��[�U���痁�т������ʂ̏����v�����AFacebook�͐�����̃R���s���[�^����J���ɏW�߂Ă����Ă��܂��B

�@�@Facebook�Ɍ���܂���B�����悤�ɑ�ʂ̃��[�U������Google�AAmazon�AApple�AEvernote�ȂǁA�����̊�Ƃ���ʂ̃R���s���[�^���W�߂��{�݁A�f�[�^�Z���^�[�ɂ���ď������s���Ă��܂��B

�@���܂�f�[�^�Z���^�[����̋���ȃR���s���[�^�V�X�e���ɂȂ����ƍl����Ηǂ��ł��傤�B

��2�@Facebook�Ђ�2012.2��IPO�\������2011�N12�����̌��ԃA�N�e�B�u�E���[�U�[����8��4500���l�ƕ��Ă���Bhttp://www.sec.gov/Archives/edgar/data/1326801/000119312512034517/d287954ds1.htmTrends in Our User Metrics, "As of December 31, 2011,we had 845 million MAUs (Monthly Active Users)�W

10Gbps�l�b�g���[�N�������߂��܂�

�@���������f�[�^�Z���^�[�ł́A�����ɂ��邷�ׂẴR���s���[�^���l�b�g���[�N�Őڑ����ď����S���Ă��܂��B

�@�����Ă��܁A�����̍������̂��߂�10Gbps�l�b�g���[�N�i���炭���Ȃ��̃p�\�R����10�{���ł��j�̓������i��ł��܂���3�B

�@�܂��܂��R���s���[�^�l�b�g���[�N�̍������͑����̂ł��B���������̍������͂��Ȃ������̃p�\�R���ɂ��������f����܂��B�܂�ƂĂ��߂������ɁA���Ȃ��̊��ɂ���p�\�R����10Gbps�Ή��ɂȂ�̂ł��B

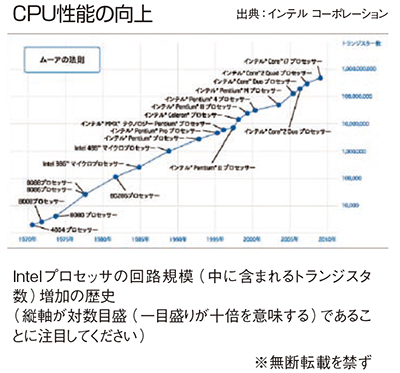

�@���̔w�i�ɂ͍���CPU�J���̋Z�p�g�����h������܂��B

�� 3�@2011 �N12 �� EE Times, http://eetimes.jp/ee/articles/1112/05/news033.html

CPU�v���j�̕ω��F����E��ʃf�[�^������

�@1970�N���̒a���ȗ��A�p�\�R����CPU�͈�т��ď������x�̌�����������Ă��܂������A2005�N���ɂ��̌��E�������Ă��܂�����4�B

�@������CPU��Ђ͔��W������P�̑��x�ł͂Ȃ�����x�A�܂蕡���̌v�Z���ɂł��邾�������s�������ɐ�ւ��܂����B���ł�Intel��8�R�A(����x�ł�16)�̐��i���Ă��܂��B

�@���������������̕ω��́A���[�U�̎g�����ɂ��ω��������炵�܂��B

�@���̎�̕���v���Z�b�T���ł��L���ɓ����p�r�̈�͑�ʃf�[�^�����ł��B�摜�����A���f�B�A�����͂��̓T�^�Ⴞ�ƍl����A�������N���ł���炪�O�ʂɉ����o����Ă������R��������Ǝv���܂���5�B

��4�@�����͔M�B1cm�l�������Ȃ�CPU��100W�ȏ㔭�M����̂����A����͓d�C�q�[�^�[�Ɠ����x�̔M�B

��5�@GPU�i�O���t�B�N�X�v���Z�b�T�j�̍��������d�v�ȗv�f�ł��邪���ʂ̐��������A�����ł͐G��Ȃ��B

�ĂђʐM�̍�������

�@�����đ�ʃf�[�^�����̂��߂ɁACPU�͍����ȃl�b�g���[�N��v�����Ă��܂��B

�@2011�N7���AIntel��10Gbit�̃l�b�g���[�N�`�b�v�i���i�j�J���ŗL����Fulcrum�Ђ����܂�����6�B

�@������Intel�Ђ�CPU��10Gbit�l�b�g���[�N�����ڂ��ꂽ�p�\�R�����i�헪�I�ȉ��i�ݒ�Łj�X���ɕ��Ԃ悤�ɂȂ�ł��傤�B

�@�����ăC���^�[�l�b�g�̐ڑ����x�A������̓]�����x���A����Ɍĉ����Ă����ƍ����ɂȂ�ł��傤�B

�@�Z�p�����p�҂̗~���������A���̎��v���Z�p���W�̔w�����Ăщ����̂ł��B

��6�@http://www.computerworld.jp/topics/629/�l�b�g���[�N���/201715/�C���e���@�g�C���e���A������ʐM�v���b�g�t�H�[���uCrystal Forest�v�\�h�@�����ɁAIntel��Crystal Forest�Ƃ��č����l�b�g���[�N���v���Z�b�T�Ɠ�������Ƃ����L��������B

�V�X�e���S�̂̃o�����X��������

�@�����܂ŁA����̎��ɂ��Ęb���܂����B�����������̘b�͊F�Ȃ����Ă��邱�Ƃ�������ł��傤���B

�@�l�b�g���[�N�̍������ACPU �̍������ɂ���āu������Ɖ摜���o��̂������Ȃ����v�u������Ə����������Ȃ����v�ȂǂƊ�Ԃ̂͗]��ɋߎ���I�ŁA���삪�����ł��B

�@������ł��傫���ς��̂̓V�X�e���S�̂̐v�o�����X�ł��B

�@�l�b�g���[�N�̍��������R���s���[�^�̋@�\���̂��̂��l�b�g���[�N�̌��������Ɉڂ����B������������Ă���f�[�^�Z���^�[���ł̒ʐM�̍��������A�Ăт��Ȃ��̃p�\�R������������B

�@���������ω��̕�����قǖʔ������Ƃ͂Ȃ��ł����B

�@����ȕ��ɍ��N���Ă���ω��̑S�̂���Ղ��A�V�X�e���S�̂�h�邪���v�̍������ǂ����ׂ����B�܂�O�����h�f�U�C���ɂ��čl���A���ۂɂ���Ɍg���@��������Ƃ͏��Z�p����̂ƂĂ��ǂ��Ƃ��낾�Ǝv���܂��B

�����ȍō����\�i

�@TOP 500�Ƃ���Web�T�C�g��������܂��B�X�[�p�[�R���s���[�^�i�X�p�R���j�ƌĂ��A���\���Ɍ��܂ō��߂��R���s���[�^�V�X�e���̏��500�������L���O���Ă��܂��B

�@�����N��ʂ�����ƁA�ŏ�ʂ́u���R���s���[�^�v�����x�m�ʐ��́i���܂茩�����Ȃ��jCPU���g���Ă��܂����A����ȊO�̃X�p�R����CPU�͂قƂ��Intel���邢��AMD���́u�N�ł����ʂɔ�����vCPU�ł��B

�@F1�}�V���̂悤�ɁA���z�̔�p���|���ē��ʂȃG���W�����J�����Đ��\���グ��̂ł͂Ȃ��A���ʂ�CPU���ʂɂȂ��ŋ���ȃV�X�e��������Ă���̂ł��B

�@����͂����������̂ł��傤�B

�@���̗��R�́A�P�̐��\�Ō���u�N�ł����ʂɔ�����vCPU���A���E�ōł������\��CPU������ł��B

�@���\�����̌��ʁA�����́A����CPU�͐��牭�~�P�ʂ̊J���������K�v�ȏɂȂ�܂����B

�@�����ăG���W���ƈ���āA�����̂͊J�������Ɋr�ׂĐ��i�P�i�̌���������̂悤�Ɉ����̂ł��B

�@���z�̓������ʂ̐��i�̔��ł܂��Ȃ��K�v�������A��ʂɔ���鐻�i�ɂ������\����ɕK�v�ȊJ���������|�����Ȃ��Ȃ��Ă��܂��B

�@�ł������ȁA�ő�̗ʔ̕i�������ō��̐��\�����B

�@������Ɩʔ����\���ł͂Ȃ��ł����H

�R���s���[�^���H�w�� �l�b�g���[�N���f�B�A�w�� ���c�@�L �u�t

- �v���t�B�[��

-

���m�i�H�w�j�B���̓l�b�g���[�N�V�X�e���B�C���^�[�l�b�g�̃g���t�B�b�N����ɂ��Č������Ă���B���ɂ����U�V�X�e���A�]�ʉۋ��A�d�q�����AThin Server�ȂǁA�����̃l�b�g���[�L���O�Ɋւ��S�ʂɋ��������B���Z�p�Ɋւ���Ⴂ�l�̂��߂̃��N���N����悤�ȏЉ�L����ǂݕ����A���Ԃɕs�����Ă���Ɗ����āA����V���R���o���[�ȂǂŎ�ށA���M�����Ȃ��B���s�s�����썂�ZOB�B