ビッグデータとAIから見える安全安心なComfortable Smart Cityへ向けて「記憶に残る快適ナビの公開デモ展示と実証実験in宮津」 開催

2018.10.30

京都大学、京都産業大学、奈良先端科学技術大学院大学、九州大学が研究開発※した「多様な歩行者への安全かつ魅力的で覚えやすいルート推奨システム」の公開デモ展示および一部の実証実験を、京都産業大学が包括連携協定を締結している京都府宮津市にて行います。

※この研究は、総務省SCOPE重点領域型研究開発推進事業の一部委託を受けています。

[研究課題名:Memorable-route Recommendation System for Safe and Attractive Paths to Diverse Kinds of Pedestrians(和訳:多様な歩行者への安全かつ魅力的で覚えやすいルート推奨システム)(#171507010)]

【本リリースのポイント】

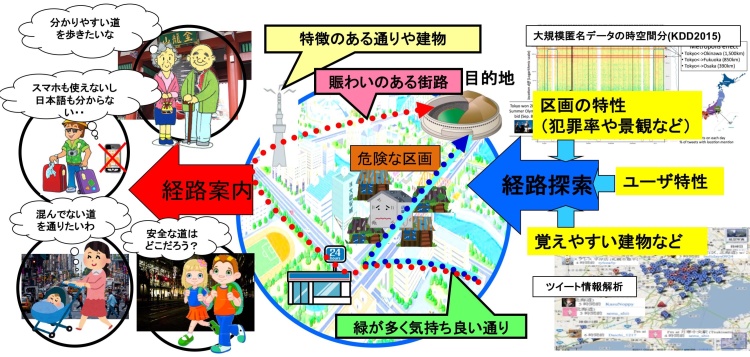

- 展示では、人流データ(SNSデータ、Google Street Viewの画像データ等)等の多種多様なデータ分析により、地理上の「Visual diversity(視覚的多様性)」「Color(色彩)」「Comfort(快適さ)」を解析・抽出することで、発見性の高いルートや緑の多いルート、母親にとって安心なルート等、安全安心で心地良いナビをデモンストレーション。

- 実証実験では、時間帯により変化する人気の店舗や通りを目印として利用することで、道に迷いにくい道案内を自動で提示し、目的地までスマートフォンのルックアップ回数を減らすことができ記憶に残る散策ナビのアプリを提供。

- 震災時の避難経路や、オリンピックなどの大規模イベントの際の道案内としての利用が可能。

| 開催日時 | 11月4日(日)10時30分~15時30分 |

|---|---|

| 開催場所 | 道の駅「海の京都 宮津」観光交流センター前特設ブース(宮津市字浜町3007) |

| その他 | 本実証実験等は10月6~7日の荒天により延期して実施するものです。 |

主な研究者

アダム・ヤトフト(京都大学大学院 情報学研究科 特定准教授)

秋山 豊和(京都産業大学 情報理工学部 教授)

河合 由起子(京都産業大学 情報理工学部 教授)

若宮 翔子(奈良先端科学技術大学院大学 研究推進機構 博士研究員)

荒牧 英治(奈良先端科学技術大学院大学 研究推進機構 特任准教授)

川崎 洋 (九州大学 システム情報科学研究院 教授)

秋山 豊和(京都産業大学 情報理工学部 教授)

河合 由起子(京都産業大学 情報理工学部 教授)

若宮 翔子(奈良先端科学技術大学院大学 研究推進機構 博士研究員)

荒牧 英治(奈良先端科学技術大学院大学 研究推進機構 特任准教授)

川崎 洋 (九州大学 システム情報科学研究院 教授)

協力機関

宮津市、海の京都DMO

ポイント

- SNSデータやGoogle Street Viewの画像データ、Wi-Fiパケットセンサによる人流データといった多種多様なデータ分析により、地理上の(1)Visual diversity(視覚的多様性)、(2)Color(色彩)、(3)Comfort(快適さ)の3つの特徴を解析・抽出します。

- 抽出された3つの特徴から、緑の多いルートや犯罪の少ないルート、通勤や散歩を楽しみたいといった安全安心で心地良い、快適な道案内を自動で提示します。

- 昼間や夜といった時間帯により変化する人気の店舗や通りをランドマークとして抽出し、目印として利用することで、環境の変化に応じた道に迷いにくい道案内を自動で提示します。今回、宮津市にて実証実験を実施します。

- また、出身地や年齢層など、属性に応じた人の流れの違いについて調査可能にするため、インセンティブを活用した事前承諾による人流データの収集および分析を行います。

- 震災時の避難経路や、オリンピックなどの大規模イベントの際の道案内としても利用可能です。

背景

欧米の主要都市では駅を中心として大量のセンサを埋め込み、電車等の情報をデジタルサイネージやスマートフォン等に配信し、利用者を効率よく目的地に誘導するといったスマートシティ構築を産官学が連携して推し進めています。大阪でもFESTIVALプロジェクトにおいて、都市部におけるSmart ICT実証実験環境の構築が進められてきました。

しかし、スマートフォンを手に持ちながら移動することは危険を伴うことが指摘されている他、GPSの精度が低いと自分がどこにいるのかが分からなくなることがあるなど、ナビゲーション時の課題解決が望まれています。特に、旅行先や、震災などでは、そのニーズが特に高いと言えます。

しかし、スマートフォンを手に持ちながら移動することは危険を伴うことが指摘されている他、GPSの精度が低いと自分がどこにいるのかが分からなくなることがあるなど、ナビゲーション時の課題解決が望まれています。特に、旅行先や、震災などでは、そのニーズが特に高いと言えます。

技術内容

Google Naviを確認しながら移動するユーザは急増していますが、移動しながら小さな画面を見て経路を確認することは危険を伴います。ランドマーク・ナビゲーション(以下ランドマークナビ)では、人が記憶しやすいランドマークを抽出することで、効率性ならびに安全性の高いナビが実現できます。これまで我々はランドマークナビとして、郵便局やコンビニのような近くまでいかないと視認できないが、 ユーザの現在位置を高い精度で同定できるもの(点のランドマークと定義)、京都タワーやスタジアムなど、遠方からでも視認できるが、現在位置をおおよそにしか同定できないもの(面のランドマークと定義)、さらに電車通りや河川のように、近くまで行かないと視認できないが、その範囲が線状に広がりを持つもの(線のランドマークと定義)の3つ(点と線と面)を視認性と注目度に基づいて抽出し、従来なし得なかった数種類のランドマークを同時に利用可能なナビゲーションを実現してきました(UbiComp2016、インタラクション2015)。今回、新たにGPS 付きモバイル端末(スマートフォン)から得られるConsumer Generated Media のSNSデータ(TwitterとFoursquare)に加えて、Google Street ViewとFlickrから得られた通りの画像データ、オープンデータとなる犯罪データを複合的に分析することで、(1)Visual diversity(視覚的多様性)、(2)Color(色彩)、(3)Comfort(快適さ)の3つの特徴を解析・抽出しました。

1つ目の「視覚的多様性」により、ルート上に様々な外観の店舗や建物が多いことで、発見と探検の機会が増え、例えば、興味深い旅を経験できる可能性をもっています。提案手法は、Googleストリートビューの街の大量画像を収集し、その経路に沿って視覚的変化の割合を算出しています。

2つ目の「色彩」により、都会にいても緑の多い環境に触れることで健康と幸福に良い影響を与えると考えています。これは不快な環境は血圧や心拍数、筋肉の緊張を高めるが、都市の緑地の知覚的なものでストレス軽減に効果的であるとの報告に基づいています。提案手法は、Googleストリートビューの画像から機械学習によりいくつかの視覚的手がかりを抽出し、それに基づいて経路の心地よさスコアを測定します。視覚的手がかりとは、色彩(特に緑色)と明るさの比率、また舗道に沿った公園や樹木、湖といったものです。

3つ目の「快適さ」では、赤ちゃんを育てる母親やお年寄りなど特別なタイプのユーザに焦点を当てています。 母親にとって混雑した通りや狭い通り、また舗装されていない通りは歩くことが難しい場合があります。 赤ちゃんを連れた母親が頻繁に使用する通りの情報は、特殊なルートの推奨に使用できます。私たちのシステムでは、特別な分類方法に基づいてベビーママ(赤ちゃん連れの母親)であるTwitterユーザを検出し、その後ジオタグ付きのツイートを使用して、歩いている場所を検出しています。

また、Wi-Fiパケットセンサから得られた人流データも加えることで、昼と夜という時間帯によって変化するランドマークも抽出します。また、出身地や年齢層など、属性に応じた移動傾向の違いについて調査可能にする上で、事前承諾を得た人流データの収集は重要な課題であり、今回、Free Wi-Fiの利用権や地元の重要文化財の観覧権といったインセンティブを活用した事前承諾に基づく人流データの取得に関する実証実験を行います。

これら新しい技術により、少ない数のランドマークを記憶して、スマートフォンなどで地図を確認するルックアップ回数を減らしつつ、周りの景色やイベントを楽しみながら目的地に到達することができます。

なお、この技術は、2018年 4月にフランスのリヨンで開催された情報学分野では国際的に最高峰となるthe Web Conference (WWW2018) に採択され、デモンストレーションを行っています。

本研究開発は今後、情報通信研究機構(NICT)の委託研究「日欧が連携する都市型Smart ICT実験環境の創出とアプリケーション実証(FESTIVALプロジェクト)」の成果として得られた、都市部におけるセンシングデータならびに実証実験環境の活用により、更なるシステムの改良ならびに実証実験を行っていく予定です。

1つ目の「視覚的多様性」により、ルート上に様々な外観の店舗や建物が多いことで、発見と探検の機会が増え、例えば、興味深い旅を経験できる可能性をもっています。提案手法は、Googleストリートビューの街の大量画像を収集し、その経路に沿って視覚的変化の割合を算出しています。

2つ目の「色彩」により、都会にいても緑の多い環境に触れることで健康と幸福に良い影響を与えると考えています。これは不快な環境は血圧や心拍数、筋肉の緊張を高めるが、都市の緑地の知覚的なものでストレス軽減に効果的であるとの報告に基づいています。提案手法は、Googleストリートビューの画像から機械学習によりいくつかの視覚的手がかりを抽出し、それに基づいて経路の心地よさスコアを測定します。視覚的手がかりとは、色彩(特に緑色)と明るさの比率、また舗道に沿った公園や樹木、湖といったものです。

3つ目の「快適さ」では、赤ちゃんを育てる母親やお年寄りなど特別なタイプのユーザに焦点を当てています。 母親にとって混雑した通りや狭い通り、また舗装されていない通りは歩くことが難しい場合があります。 赤ちゃんを連れた母親が頻繁に使用する通りの情報は、特殊なルートの推奨に使用できます。私たちのシステムでは、特別な分類方法に基づいてベビーママ(赤ちゃん連れの母親)であるTwitterユーザを検出し、その後ジオタグ付きのツイートを使用して、歩いている場所を検出しています。

また、Wi-Fiパケットセンサから得られた人流データも加えることで、昼と夜という時間帯によって変化するランドマークも抽出します。また、出身地や年齢層など、属性に応じた移動傾向の違いについて調査可能にする上で、事前承諾を得た人流データの収集は重要な課題であり、今回、Free Wi-Fiの利用権や地元の重要文化財の観覧権といったインセンティブを活用した事前承諾に基づく人流データの取得に関する実証実験を行います。

これら新しい技術により、少ない数のランドマークを記憶して、スマートフォンなどで地図を確認するルックアップ回数を減らしつつ、周りの景色やイベントを楽しみながら目的地に到達することができます。

なお、この技術は、2018年 4月にフランスのリヨンで開催された情報学分野では国際的に最高峰となるthe Web Conference (WWW2018) に採択され、デモンストレーションを行っています。

本研究開発は今後、情報通信研究機構(NICT)の委託研究「日欧が連携する都市型Smart ICT実験環境の創出とアプリケーション実証(FESTIVALプロジェクト)」の成果として得られた、都市部におけるセンシングデータならびに実証実験環境の活用により、更なるシステムの改良ならびに実証実験を行っていく予定です。

公開デモサイト

Comfortable Navi Beta route search

Landmark Navi Beta route search

AR Landmark Navi Beta route search

Landmark Navi Beta route search

AR Landmark Navi Beta route search

- お問い合わせ先

-

Adam Jatowt (アダム・ヤトフト)

京都大学大学院 情報学研究科 社会情報学専攻 特定准教授

Tel.075-753-5909

adam@dl.kuis.kyoto-u.ac.jp

※尚、日本語による問合せをご希望の際には奈良先端科学技術大学院大学にご連絡下さい。秋山 豊和(あきやま・とよかず)

京都産業大学 情報理工学部 教授

Tel.075-705-1531

akiyama@cc.kyoto-su.ac.jp荒牧 英治(あらまき・えいじ)

奈良先端科学技術大学院大学 研究推進機構 特任准教授

Tel.0743-72-6053

socialcomputing-office@is.naist.jp川崎 洋(かわさき・ひろし)

九州大学 システム情報科学研究院 教授

Tel.092-802-3571

koffice@ait.kyushu-u.ac.jp